Google bringt Gemini 3 Flash auf den Markt

Gemini 3 Flash basiert auf der Gemini-3-Architektur und erzielt in mehreren wichtigen Tests Ergebnisse, die mit den fortschrittlichsten Modellen vergleichbar sind. Die letzte Prüfung der Menschheit Es erreichte 33,7 %, was fast dreimal so viel ist wie beim Vorgänger (11 %) und vergleichbar mit dem GPT‐5.2 (34,5 %) und dem Gemini 3 Pro (37,5 %).

Im multimodalen Test MMMU-Pro, der das Verständnis von Bildern, Texten, Tönen und anderen Daten prüft, übertraf das neue Modell alle Konkurrenten mit einer herausragenden Punktzahl von 81,2 %.

Standardmodell für Benutzer weltweit

Gemini 3 Flash wird ab sofort das Standardmodell in Gemini sein und ersetzt Version 2.5 Flash. Benutzer können weiterhin auf das Pro-Modell wechseln, wenn sie fortgeschrittenere Mathematik- oder Programmierlösungen benötigen.

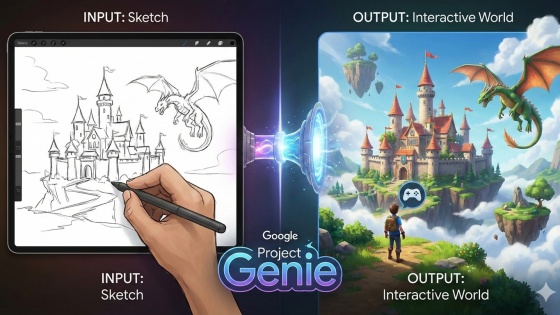

Das neue Modell bietet eine bessere Interpretation multimodaler Inhalte und ermöglicht Aufgaben wie:

- Analyse des Videos des Nutzers,

- Interpretation von Skizzen oder Zeichnungen,

- Verarbeitung von Audioaufnahmen,

- Erstellung von Quizfragen oder audiobasierten Inhalten,

- Vorbereitung von Anwendungsprototypen.

Gemini 3 Flash versteht die Benutzerabsicht besser, erstellt visuell ansprechendere Antworten (Tabellen, Bilder) und ermöglicht eine verbesserte Nachverfolgung von Elementen über mehrere Erstellungsschritte hinweg.

Für Unternehmen und Entwickler

Unternehmen wie JetBrains, Figma, Cursor, Harvey und Latitude nutzen das neue Modell bereits über Vertex AI und Gemini Enterprise. Es steht Entwicklern als API-Vorschau und in Googles neuem Programmierwerkzeug Antigravity zur Verfügung.

Laut Google erzielt der Gemini 3 Pro im SWE-bench-verifizierten Codierungstest 78 %-Punkte und liegt damit nur hinter GPT-5.2. Das neue Flash-Modell eignet sich aufgrund seiner Geschwindigkeit besonders gut für Videoanalyse, Datenextraktion und schnelle, wiederholbare Arbeitsabläufe.

Preise:

- 0,50 US-Dollar pro 1 Million Input-Tokens

- 3,00 US-Dollar pro 1 Million Output-Token.

Das Modell ist etwas teurer als der Gemini 2.5 Flash, aber Google behauptet, es sei dreimal schneller und verbrauche 30 % weniger Tokens bei "Denkaufgaben", was die Gesamtkosten senken könne.

Google und OpenAI werden immer erbittertere Konkurrenten.

Google verarbeitet täglich über eine Billion Tokens über die Gemini-APIs, während sich der Wettbewerb mit OpenAI verschärft. Jüngsten Berichten zufolge rief Sam Altman Anfang des Monats intern den Alarmzustand aus, nachdem der Traffic von ChatGPT zurückging, während die Nutzerbasis von Gemini wuchs.

Google äußert sich nicht offiziell zu den „Match-Ergebnissen“, räumt aber ein, dass die rasche Veröffentlichung neuer Modelle in der Branche „alle Akteure dazu anregt, Innovationen voranzutreiben“ und neue Methoden zur Bewertung der Qualität von Modellen zu entwickeln.