Cómo la falta de datos amenaza el futuro de la inteligencia artificial

El mundo de la inteligencia artificial se enfrenta a la escasez de su materia prima más valiosa: los datos. Esto ha suscitado debates sobre una alternativa cada vez más popular: los datos sintéticos o incluso "falsos". Durante años, empresas como OpenAI y Google han estado extrayendo datos de internet para entrenar los grandes modelos de lenguaje (LLM) que impulsan sus soluciones de IA. Estos modelos han procesado ingentes cantidades de contenido generado por humanos, desde artículos de investigación y novelas hasta vídeos de YouTube.

Ahora estos datos se están agotando lentamente y su cantidad es cada vez más limitada. Algunos actores importantes en este campo, como el director de OpenAI, Sam Altman, creen que los modelos de autoaprendizaje podrán utilizar datos sintéticos, lo que proporcionaría una fuente de datos barata y casi infinita.

Sin embargo, los investigadores advierten de los riesgos. Los datos sintéticos podrían reducir la calidad de los modelos, ya que pueden estar contaminados con sus propios errores. Investigación de las universidades de Oxford y Cambridge Demostraron que alimentar los modelos exclusivamente con datos sintéticos genera resultados deficientes y sin sentido. En su opinión, un uso equilibrado de datos sintéticos y reales es clave.

Cada vez más empresas crean datos sintéticos

La falta de datos lleva a las empresas a buscar alternativas, como datos sintéticos generados por sistemas UI basados en datos reales. Las empresas de tecnología, incluidas OpenAI y Google, entre otras, ya están pagando millones para acceder a datos de plataformas como Reddit y varios medios de comunicación, a medida que los sitios web restringen cada vez más el uso gratuito de su contenido. Sin embargo, los recursos son limitados.

Nvidia, Tencent y las nuevas empresas Gretel y SynthLabs están desarrollando herramientas para crear datos sintéticos que a menudo son más limpios y específicos que los datos generados por humanos. Con Llama 3.1, Meta utilizó datos sintéticos para mejorar habilidades como programación y resolución de problemas matemáticos. Los datos sintéticos también ofrecen la posibilidad de reducir el sesgo inherente a los datos reales, aunque los investigadores advierten que garantizar la precisión y la imparcialidad sigue siendo un desafío importante.

Inteligencia artificial “Habsburgo”

Si bien los datos sintéticos aportan ventajas, también plantean graves riesgos. MetaInvestigación sobre el Modelo Llama 3.1 demostró que entrenar un modelo con sus propios datos sintéticos puede degradar su rendimiento. De igual manera, estudio en la revista Nature Advirtieron que el uso incontrolado de datos sintéticos conduce al «colapso del modelo», lo cual los investigadores compararon con la degeneración genética y denominaron simbólicamente al fenómeno «inteligencia artificial de los Habsburgo», término acuñado por el investigador Jathan Sadowski.

La pregunta principal sigue siendo: ¿cuántos datos sintéticos son demasiados? Algunos expertos sugieren usar datos híbridos, donde los datos sintéticos se combinan con datos reales para evitar la degradación del modelo. Empresas como Scale AI están explorando este enfoque, y su director ejecutivo, Alexandr Wang, cree que el enfoque híbrido es "el verdadero futuro".

Encontrar nuevas soluciones

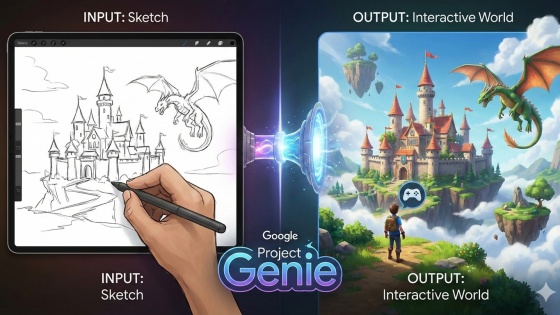

En enero, Google DeepMind presentó AlphaGeometry, un sistema que resuelve problemas geométricos de alto nivel mediante un enfoque neurosimbólico. Combina las ventajas del aprendizaje profundo intensivo en datos y el razonamiento basado en reglas. El modelo se entrenó íntegramente con datos sintéticos y se considera un posible avance hacia la inteligencia artificial general.

El campo neurosimbólico es todavía joven, pero podría ofrecer una dirección prometedora para el futuro del desarrollo de la inteligencia artificial. Bajo la presión de la monetización, empresas como OpenAI, Google y Microsoft intentarán todas las soluciones posibles para superar la crisis de datos.