Kako nedostatak podataka ugrožava budućnost umjetne inteligencije

Svijet umjetne inteligencije suočava se s nedostatkom svoje najvrjednije sirovine – podataka. To je potaknulo rasprave o sve popularnijoj alternativi: sintetičkim ili čak „lažnim“ podacima. Godinama tvrtke poput OpenAI-a i Googlea rudare podatke s interneta kako bi obučavale modele velikih jezika (LLM) koji pokreću njihova AI rješenja. Ti su modeli probavili ogromne količine sadržaja koji su generirali ljudi, od istraživačkih radova i romana do YouTube videa.

Sada tih podataka polako ponestaje, njihova količina postaje sve ograničenija. Određeni glavni igrači na tom polju, poput direktora OpenAI-ja Sama Altmana, vjeruju da će samoučeći modeli moći koristiti sintetičke podatke, što bi predstavljalo jeftin i gotovo beskonačan izvor podataka.

Međutim, istraživači upozoravaju na rizike. Sintetički podaci mogli bi smanjiti kvalitetu modela, jer mogu biti „otrovani“ vlastitim pogreškama. Istraživanja sveučilišta Oxford i Cambridge pokazali su da isključivo hranjenje modela sintetičkim podacima dovodi do loših rezultata i „besmislenosti“. Po njihovom mišljenju, ključna je uravnotežena upotreba sintetičkih i stvarnih podataka.

Sve više tvrtki stvara sintetičke podatke

Nedostatak podataka navodi tvrtke da traže alternative, poput sintetičkih podataka koje generiraju UI sustavi na temelju stvarnih podataka. Tehnološke tvrtke, uključujući OpenAI i Google, već plaćaju milijune za pristup podacima s platformi poput Reddita i raznih medijskih kuća, jer web stranice sve više ograničavaju besplatnu upotrebu svojih sadržaja. Međutim, resursi su ograničeni.

Nvidia, Tencent i startupi Gretel i SynthLabs razvijaju alate za stvaranje sintetičkih podataka koji su često čišći i specifičniji od podataka koje generiraju ljudi. S Llama 3.1, Meta je koristila sintetičke podatke za poboljšanje vještina kao što su programiranje i rješavanje matematičkih problema. Sintetički podaci također nude mogućnost smanjenja pristranosti svojstvene stvarnim podacima, iako istraživači upozoravaju da osiguravanje točnosti i nepristranosti ostaje veliki izazov.

"Habsburška" umjetna inteligencija

Iako sintetički podaci donose prednosti, oni također predstavljaju ozbiljne rizike. Meta istraživanje o modelu Llama 3.1 pokazalo je da treniranje modela na vlastitim sintetičkim podacima zapravo može smanjiti njegove performanse. Slično tome, studija u časopisu Nature upozorio je da nekontrolirana upotreba sintetičkih podataka dovodi do „kolapsa modela“, što su istraživači usporedili s genetskom degeneracijom i simbolično nazvali fenomen „habsburška umjetna inteligencija“. Termin koji je skovao istraživač Jathan Sadowski.

Glavno pitanje ostaje: koliko je sintetičkih podataka previše? Neki stručnjaci predlažu korištenje hibridnih podataka, gdje se sintetički podaci kombiniraju sa stvarnim podacima kako bi se spriječila degradacija modela. Tvrtke poput Scale AI istražuju ovaj pristup, a njihov izvršni direktor Alexandr Wang vjeruje da je hibridni pristup „prava budućnost“.

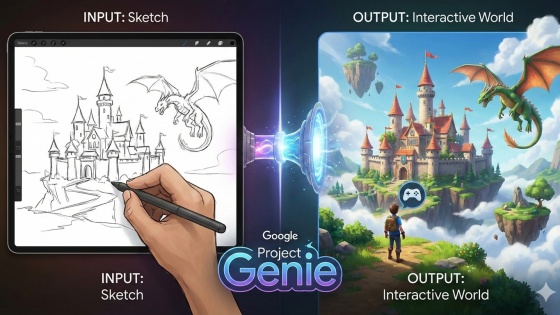

Pronalaženje novih rješenja

U siječnju je Google DeepMind predstavio AlphaGeometry, sustav koji rješava geometrijske probleme na izuzetno visokoj razini koristeći „neuro-simbolički“ pristup. Kombinira prednosti dubokog učenja s intenzivnom obradom podataka i zaključivanja temeljenog na pravilima. Model je u potpunosti obučen na sintetičkim podacima i smatra se potencijalnim korakom prema općoj umjetnoj inteligenciji.

Neuro-simboličko područje je još uvijek mlado, ali moglo bi ponuditi obećavajući smjer za budućnost razvoja umjetne inteligencije. Pod pritiskom monetizacije, tvrtke poput OpenAI-ja, Googlea i Microsofta isprobat će sva moguća rješenja za prevladavanje podatkovne krize.