Google lancia Gemini 3 Flash

Gemini 3 Flash si basa sull'architettura Gemini 3 e raggiunge risultati paragonabili ai modelli più avanzati in diversi test chiave. Nel test L'ultimo esame dell'umanità Ha raggiunto 33,7 %, ovvero quasi tre volte in più rispetto al suo predecessore (11 %) e paragonabile al GPT‑5.2 (34,5 %) e al Gemini 3 Pro (37,5 %).

Nel test multimodale MMMU-Pro, che valuta la comprensione di immagini, testo, suoni e altri dati, il nuovo modello ha superato tutti i concorrenti con un punteggio eccezionale di 81,2 %.

Modello predefinito per gli utenti di tutto il mondo

Gemini 3 Flash sarà ora il modello predefinito in Gemini, in sostituzione della versione 2.5 Flash. Gli utenti potranno comunque passare al modello Pro quando necessitano di soluzioni matematiche o di programmazione più avanzate.

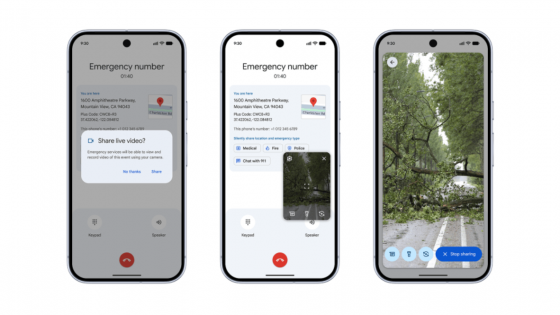

Il nuovo modello offre una migliore interpretazione dei contenuti multimodali e consente attività quali:

- analisi del video dell'utente,

- interpretazione di schizzi o disegni,

- elaborazione di registrazioni audio,

- generare quiz o contenuti audio,

- preparazione di prototipi applicativi.

Gemini 3 Flash comprende meglio le intenzioni dell'utente, crea risposte visivamente più ricche (tabelle, immagini) e consente un monitoraggio migliorato degli elementi in più fasi di creazione.

Per aziende e sviluppatori

Aziende come JetBrains, Figma, Cursor, Harvey e Latitude stanno già utilizzando il nuovo modello tramite Vertex AI e Gemini Enterprise. È disponibile per gli sviluppatori in un'anteprima API e nel nuovo strumento di programmazione Antigravity di Google.

Google afferma che Gemini 3 Pro ha ottenuto un punteggio di 78 % nel test di codifica verificato da SWE-bench, secondo solo a GPT-5.2. Il nuovo modello Flash è particolarmente adatto per l'analisi video, l'estrazione di dati e flussi di lavoro rapidi e ripetibili grazie alla sua velocità.

Prezzi:

- $ 0,50 per 1 milione di token di input,

- $ 3,00 per 1 milione di token in uscita.

Il modello è leggermente più costoso del Gemini 2.5 Flash, ma Google afferma che è tre volte più veloce e utilizza 30 token % in meno per le attività di "pensiero", il che può ridurre i costi complessivi.

Google e OpenAI sono rivali sempre più agguerriti

Google elabora oltre 1 trilione di token al giorno tramite le API di Gemini, mentre la competizione con OpenAI si intensifica. Secondo recenti report, Sam Altman ha dichiarato un "Codice Rosso" interno all'inizio di questo mese, dopo che il traffico di ChatGPT è diminuito mentre la base utenti di Gemini è cresciuta.

Google non commenta ufficialmente i "risultati delle partite", ma riconosce che il rapido rilascio di nuovi modelli nel settore "incoraggia tutti gli operatori a innovare" e a sviluppare nuovi metodi per valutare la qualità dei modelli.