人工智能领域能源浪费的终结?

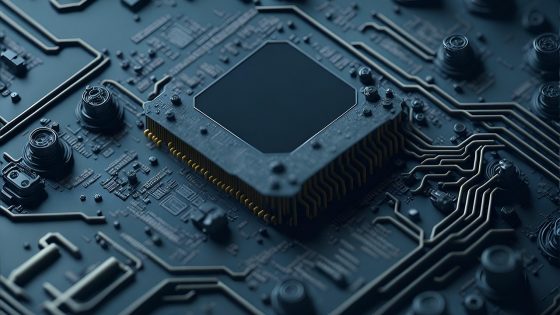

传统的计算机架构(冯·诺依曼架构)基于处理器和内存的分离,这成为现代人工智能运算的瓶颈。一种将于2026年推出的新型芯片克服了这一障碍,它直接在数据存储的位置执行计算操作。这种受神经形态工程(模仿生物神经网络)启发的方法,与我们目前使用的标准图形处理器(GPU)相比,功耗降低了90倍以上。

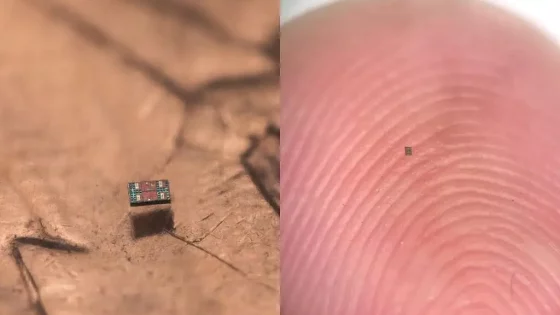

该芯片采用先进的忆阻器,能够同时存储数据并执行逻辑运算。实际上,这意味着智能手机或自动驾驶汽车等设备无需连接远程云端,即可在本地处理复杂的AI任务(例如图像识别或自然语言处理)。这不仅提高了响应速度,而且由于数据始终保留在设备内部,因此也显著提升了用户隐私。

对于斯洛文尼亚的工业和物联网设备开发商而言,这项突破标志着一个新时代的到来。以往只能收集数据的小型传感器现在能够实时做出决策,电池续航时间也将从几天延长至数月。尽管该技术目前仍处于量产优化阶段,但分析师预测,首批商用芯片将于2026年底上市。这些芯片上市初期价格预计较高(每片约150欧元),但随着应用范围的扩大,价格将迅速下降,从而能够应用于从智能家居到工业机器人等各种设备。