La fin du gaspillage d'énergie pour l'intelligence artificielle ?

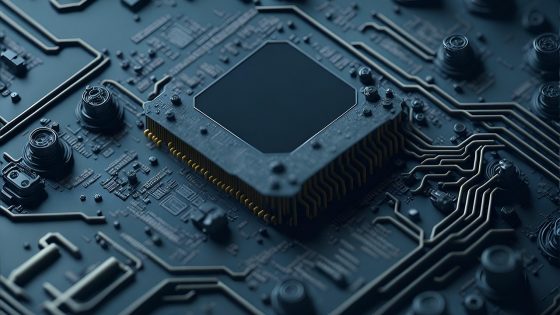

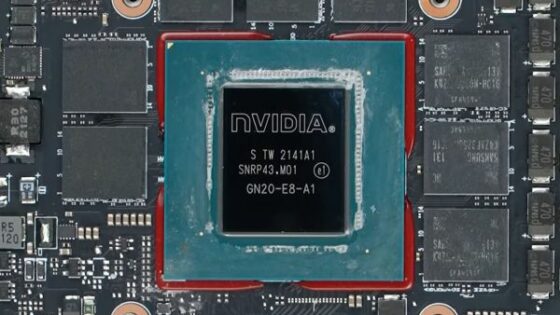

L'architecture informatique traditionnelle (de Von Neumann) repose sur la séparation du processeur et de la mémoire, ce qui constitue un goulot d'étranglement pour les opérations d'IA modernes. Une nouvelle puce, introduite en 2026, surmonte cet obstacle en effectuant les calculs directement là où les données sont stockées. Cette approche, inspirée de l'ingénierie neuromorphique (qui imite les réseaux neuronaux biologiques), réduit la consommation d'énergie de plus de 90 % par rapport aux unités de traitement graphique (GPU) standard que nous utilisons actuellement.

La puce utilise des memristors avancés capables de stocker des données et d'effectuer simultanément des opérations logiques. Concrètement, cela signifie que des appareils comme les smartphones ou les véhicules autonomes peuvent traiter localement des tâches d'IA complexes (telles que la reconnaissance d'images ou le traitement du langage naturel), sans connexion à un cloud distant. Ceci améliore non seulement la réactivité, mais renforce aussi considérablement la confidentialité des données, car celles-ci ne quittent jamais l'appareil.

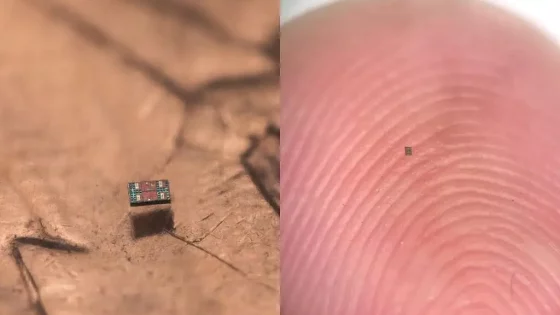

Pour l'industrie slovène et les développeurs d'objets connectés, cette avancée marque le début d'une nouvelle ère. Les petits capteurs qui, jusqu'à présent, se contentaient de collecter des données, pourront désormais prendre des décisions en temps réel, grâce à une autonomie de plusieurs mois au lieu de quelques jours. Bien que la technologie soit encore en phase d'optimisation pour la production de masse, les analystes prévoient que les premières puces commerciales seront disponibles d'ici fin 2026. Leur prix devrait être plus élevé au lancement (environ 150 euros l'unité), mais diminuera rapidement avec l'essor de leur utilisation, permettant ainsi leur intégration dans de nombreux domaines, des maisons intelligentes aux robots industriels.