La fine dello spreco energetico per l'intelligenza artificiale?

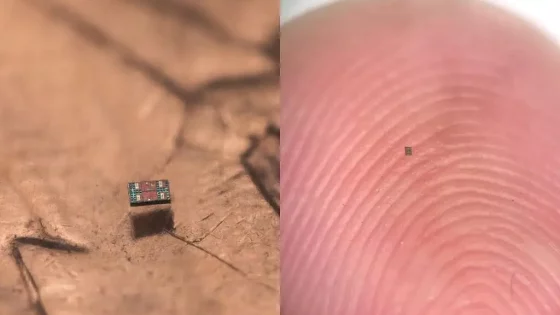

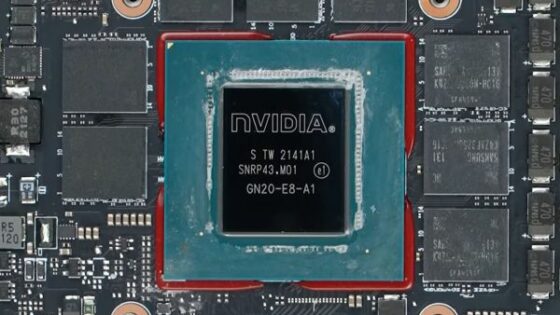

L'architettura informatica tradizionale (Von Neumann) si basa sulla separazione tra processore e memoria, che crea un collo di bottiglia per le moderne operazioni di intelligenza artificiale. Un nuovo chip, introdotto nel 2026, supera questo ostacolo eseguendo le operazioni computazionali direttamente dove sono archiviati i dati. Questo approccio, ispirato all'ingegneria neuromorfica (che imita le reti neurali biologiche), riduce il consumo energetico di oltre il 90% rispetto alle unità di elaborazione grafica (GPU) standard che utilizziamo oggi.

Il chip utilizza memristori avanzati in grado di memorizzare dati ed eseguire simultaneamente operazioni logiche. In pratica, ciò significa che dispositivi come smartphone o veicoli autonomi possono elaborare localmente complesse attività di intelligenza artificiale (come il riconoscimento delle immagini o l'elaborazione del linguaggio naturale), senza doversi connettere a cloud remoti. Ciò non solo aumenta la velocità di risposta, ma migliora anche drasticamente la privacy dell'utente, poiché i dati non lasciano mai il dispositivo.

Per l'industria slovena e gli sviluppatori di dispositivi IoT, questa svolta segna una nuova era. I piccoli sensori che in precedenza si limitavano a raccogliere dati saranno ora in grado di prendere decisioni in tempo reale, con una batteria che durerà mesi anziché giorni. Sebbene la tecnologia sia attualmente ancora in fase di ottimizzazione per la produzione di massa, gli analisti prevedono che i primi chip commerciali saranno disponibili entro la fine del 2026. Il prezzo di questi chip dovrebbe essere più alto al momento del lancio (circa 150 euro per unità), ma diminuirà rapidamente con l'espansione del loro utilizzo, consentendone l'integrazione in qualsiasi ambito, dalle case intelligenti ai robot industriali.